EU-AI-Act - Was Sie bereits jetzt wissen sollten

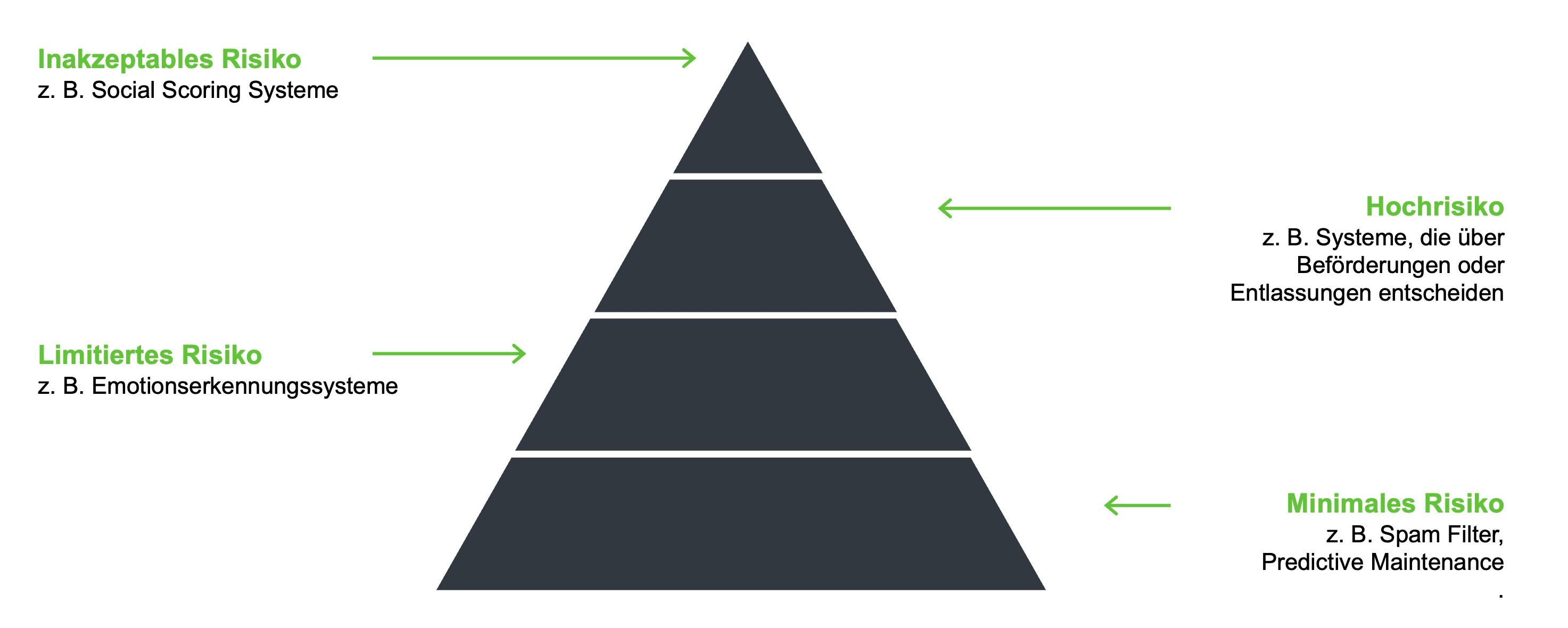

Der AI-Act soll den Vertrieb und die Nutzung von KI-Systemen in der EU regeln und vereinheitlichen, um die Werte der EU zu schützen, einen sicheren Rechtsrahmen zu schaffen. Die Basis der Verordnung ist ein risikobasierter Ansatz zur Einstufung der KI-Systeme in die Kategorien inakzeptables Risiko, Hochrisiko, limitiertes Risiko und minimales Risiko. Je nach Einstufung gelten unterschiedliche Verbote bzw. Anforderungen, um die Vertrauenswürdigkeit von KI-System zu gewährleisten. Auch wenn die Anforderungen erst 2026 in Kraft treten werden, ist es für Anbieter und Händler von KI-Systemen bereits jetzt ratsam, sich im Detail mit dem neuen Rechtsrahmen zu beschäftigen, um genug Zeit für eventuelle Anpassungen zu haben und so handlungsfähig zu bleiben. In diesem Artikel erfahren Sie, worauf Sie achten sollten.

Der europäische AI-Act - was bisher geschah

Die Nutzung von künstlicher Intelligenz ist in den letzten Jahren immer alltagstauglicher geworden. Teils denken wir nicht mehr darüber nach, wenn wir unsere Bestellungen über Sprachassistenten aufgeben, oder dass hinter dem nächsten Songvorschlag in Streaming-Diensten ein Algorithmus steckt, der unsere Präferenzen analysiert hat.

Bereits in der Vergangenheit haben einzelne Mitgliedsstaaten der EU begonnen, Anforderungen an KI zu formulieren. Beispielsweise hatte Italien im vergangenen Jahr ein Verbot für ChatGPT ausgesprochen – auch weitere Mitgliedstaaten, so wird es in den Erwägungsgründen des AI-Acts beschrieben, hatten Gesetze zur Regelung von KI-Systemen geplant. Da unterschiedliche Anforderungen innerhalb der EU zu Problemen im Binnenmarkt führen können und für Händler keine Rechtssicherheit bestünde, wurde eine Europäische Lösung angestrebt.

2021 präsentierte die Europäische Kommission einen ersten Vorschlag für den AI-Act. Über diesen wurde viel diskutiert und verhandelt. Am 8. Dezember 2023 wurde dann die vorerst finale Einigung erzielt. Wenn der Text formal bestätigt wird, wird die Verordnung voraussichtlich 20 Tage nach der Veröffentlichung in Kraft treten. Die Übergangszeit, bis die Verordnung anwendbar wird, beträgt zwei Jahre, wobei einige Bestimmungen bereits früher anzuwenden sind.

Um diese Übergangszeit zu überbrücken, wird die Kommission einen AI-Pakt veröffentlichen. Dieser wird die wichtigsten Verpflichtungen aus dem AI-Act enthalten, sodass Entwicklerinnen und Entwickler sich auf freiwilliger Basis an ihm orientieren können, um frühzeitig alle zukünftigen Vorschriften einzuhalten.

Die Verordnung wird bereits jetzt in Bezug auf ihre Tragweite mit der Einführung der DSGVO verglichen – die europäischen Vorgaben könnten sich sukzessive zu einem globalen Standard entwickeln, da die meisten KI-Lösungen aus den USA und Asien kommen, die wiederum auch zukünftig den europäischen Markt bedienen wollen. Auch die USA arbeiten an einer Regulierung, hängen zeitlich jedoch hinterher. Es ist anzunehmen, dass die großen Tech-Unternehmen Druck ausüben und fordern werden, dass die amerikanische Gesetzgebung sich an der europäischen orientieren solle. So würde Rechtssicherheit bei transatlantischen Aufträgen sichergestellt werden. Es dürfte keinesfalls im Interesse amerikanischer Anbieter sein, die europäische Gesetzgebung zu ignorieren.

Ziel des AI-Acts

Die oberste Priorität des AI-Acts ist der Schutz der Grundrechte der Menschen in der EU. Es soll sichergestellt werden, dass KI sicher, menschenrechtskonform und demokratisch ist. Auf der Basis eines risikobasierten Ansatzes wurde aus diesem Grund ein Rechtsrahmen geschaffen.

In der Verordnung wird jedoch auch hervorgehoben, dass Firmen bei der Entwicklung von neuen KI-Anwendungen nicht per se beeinträchtigt werden sollen. Der Nutzen von KI für die Wirtschaft und die Gesellschaft wird anerkannt — die Verordnung soll somit auch Anreize für Unternehmen schaffen, neue KI zu entwickeln.

KI-Basismodelle werden nach langer Diskussion ebenfalls mit in die Verordnung einbezogen, um dafür zu sorgen, dass auch KI-Systeme ohne spezifisches Einsatzgebiet vertrauenswürdigen Regelungen unterliegen.

Geltungsbereich und Inhalte des AI-Acts

Die Verordnung definiert KI-Systeme als Software, die mit einer oder mehreren in der Verordnung definierten Techniken und Konzepte entwickelt worden ist. Diese Techniken umfassen das maschinelle Lernen, logik- und wissensgestützte Konzepte und statistische Ansätze.

Nach der Definition können die Ergebnisse der KI-Systeme Inhalte, Vorhersagen, Empfehlungen, oder Entscheidungen sein und werden von einer Reihe von Zielen, die vom Menschen festgelegt werden, beeinflusst. Da diese Definition bewusst sehr weit gefasst ist, kommt es bei der Auslegung/Anwendung des AI-Acts vor allem auf die risikobasierte Unterscheidung an:

- KI-Systeme mit einem unannehmbaren Risiko dürfen gar nicht in Verkehr gebracht, in Betrieb genommen, oder verwendet werden, da sie Werte der EU, bspw. Grundrechte, verletzen. Techniken, die hier beinhaltet sind, sind beispielsweise Social Scoring Systeme, oder manipulative Systeme, die insbesondere vulnerable Personengruppen beeinflussen könnten.

- Hochrisiko-KI-Systeme, die nach Einschätzung der Verfasser erhebliche Risiken für die Gesundheit und Sicherheit oder die Grundrechte von Personen haben können, müssen strengen Auflagen entsprechen und einem Konformitätsbewertungsverfahren unterzogen werden, bevor sie in der Europäischen Union in Verkehr gebracht werden dürfen. Dieses Bewertungsverfahren kann entweder intern, oder durch eine Behörde durchgeführt werden. Die Anforderungen beziehen sich unter anderem auf die Qualität der Datensätze, die technische Dokumentation und die Sicherheit der Ergebnisse. Auch eine menschliche Aufsicht muss gewährleistet werden. Des Weiteren sollen diese Systeme in eine Datenbank aufgenommen werden. Sind alle Anforderungen erfüllt, wird ein CE-Kennzeichen vergeben. Zu den Hochrisiko-Systemen zählen Systeme, die in folgenden Bereichen Einsatz finden:

‣ Biometrische Identifizierung und Kategorisierung natürlicher Personen

‣ Verwaltung und Betrieb kritischer Infrastrukturen

‣ Allgemeine und berufliche Bildung

‣ Beschäftigung, Personalmanagement und Zugang zur Selbstständigkeit

‣ Zugänglichkeit und Inanspruchnahme grundlegender privater und öffentlicher Dienste und Leistungen

‣ Strafverfolgung

‣ Migration, Asyl und Grenzkontrolle

‣ Rechtspflege und demokratische Prozesse

Die Liste der aufgeführten Systeme ist nicht endgültig und kann in Zukunft bei Bedarf angepasst werden. Nutzer von Hochrisiko-KI-Systemen verpflichten sich, die Systeme nur gemäß der Gebrauchsanweisung zu verwenden. - Für KI-Systeme, die kein hohes Risiko darstellen, gelten die strengen Regeln nicht. Es sollen allerdings Anreize geschaffen werden, sodass Anbieter freiwillig die Anforderungen an Hochrisiko-KI-Systeme einhalten. Es steht ihnen außerdem offen, freiwillige Kodizes zu entwickeln, die sich beispielsweise auf die ökologische Nachhaltigkeit, oder die Barrierefreiheit beziehen.

- Vom grundlegenden Risikoansatz abweichend, ist die Einstufung von sogenannten Basis-Modellen, die bei generativen Text- und Bildmodellen zum Einsatz kommen. Die spezifische Risikoeinschätzung soll hier unter anderem auf der genutzten Rechenpower, der Anzahl professioneller Nutzerinnen und Nutzer und der Funktion beruhen. Diese Modelle müssen spezifische Transparenzpflichten erfüllen, die vor allem auf die technische Dokumentation und die verwendeten, teils urheberrechtlich geschützten, Daten abzielen. Auch die Kennzeichnung von entsprechend generierten Inhalten wird adressiert. Generell gilt, dass diese Modelle keine illegalen Inhalte erzeugen dürfen. Für generative Modelle mit erheblichen Auswirkungen (z. B. durch eine sehr hohe Rechenleistung) gelten außerdem weitere Pflichten in Bezug auf Überwachung und das Verhindern von Angriffen durch Dritte.

Systeme, die ausschließlich für militärische Zwecke entwickelt und verwendet werden, werden explizit aus der Verordnung ausgeschlossen, wenn sie nur für die gemeinsame Außen- und Sicherheitspolitik verwendet werden. Auch Behörden in Drittländern und internationale Organisationen werden ausgeschlossen, wenn sie KI-Systeme im Bereich der Strafverfolgung im Rahmen internationaler Übereinkünfte verwenden.

Ein weiterer Fokus liegt auf der Transparenz für die Öffentlichkeit: Generell gilt, dass Systeme, die mit natürlichen Personen interagieren, so konzipiert sein müssen, dass den natürlichen Personen mitgeteilt wird, dass es sich um ein KI-System handelt. Bei biometrischen Kategorisierungen und Emotionserkennung muss ein entsprechender expliziter Hinweis diesbezüglich erfolgen. Auch Deepfakes dürfen ohne entsprechende Kennzeichnung nicht mehr erstellt werden. Ausnahmen bestehen nur im Rahmen der Strafverfolgung.

Die Risikoklassifizierungen im Überblick:

Was bedeutet der AI-Act für Unternehmen

Die in dem Rechtstext vor allem für Hochrisiko-KI-Systeme genannten Anforderungen gelten nicht nur für die Hersteller solcher Systeme, sondern auch für Einführer, Händler und Bevollmächtigte (eine in der EU ansässige Person in Vertretung für einen außerhalb der EU niedergelassenen Anbieter).

Generell müssen Einführer und Händler vor der Markteinführung eines Hochrisiko-Systems sicherstellen, dass das System alle Anforderungen erfüllt und alle Verfahren zur Konformitätsbewertung durchgeführt wurden. Auch die Vergabe des CE-Kennzeichens wird kontrolliert. Sollte Grund zu der Annahme bestehen, dass das entsprechende System nicht konform ist, darf das Produkt nicht auf dem Markt bereitgestellt werden.

Sollten Akteure in der Lieferkette ein Hochrisiko-KI-System unter ihrem Namen vertreiben, oder eine wesentliche Änderung am System vornehmen, gelten sie in diesem Fall als Anbieter und müssen für das System die entsprechende Verantwortung übernehmen.

Es besteht eine Beobachtungs- und Meldepflicht für Anbieter von KI-Systemen. Das bedeutet: Sollten Vorfälle, oder Fehlfunktionen bekannt werden, die dazu führen, dass die entsprechenden Systeme nicht mehr den Vorgaben entsprechen, müssen diese gemeldet werden.

Eine noch zu errichtende Marktüberwachungsbehörde erhält die Befugnisse sowohl Trainings- und Testdaten als auch unter Umständen den Quellcode beim Anbieter einzusehen, um die Konformität bewerten zu können.

Bei Verstößen gegen die Anforderungen drohen zum Teil empfindliche Geldstrafen. Dementsprechend sollte die Einstufung eines KI-Systems nicht leichtfertig erfolgen und im Zweifelsfalls nach rechtlicher Beratung durchgeführt werden. Grundlage für die Einstufung ist hierbei die Risikobewertung. Auch sollte bereits jetzt geprüft werden, ob und in welchem Maße die Anforderungen an das Qualitätsmanagementsystem und die Transparenz- und Dokumentationspflichten erfüllt werden, um bei Bedarf frühzeitig nachbessern zu können.

Neben allen Pflichten ist auch die Errichtung von KI-Reallaboren geplant, die die Entwicklung von innovativen KI-Systemen fördern sollen. Insbesondere Kleinanbieter und Start-ups sollen so bei der Entwicklung von neuen Systemen gefördert und unterstützt werden.

Wenn Sie wissen möchten, ob und wie ihre KI vom EU-AI-ACT betroffen ist, hilft Cassini Ihnen gerne mit einer Risikoanalyse und einer Bewertung weiter. Auch bei der Entwicklung von Data Management und Data Governance Systemen unterstützen wir Sie gerne!