Explainable AI – Geht das? Und wenn ja, wie?

Künstliche Intelligenz (KI) wird als eine der entscheidenden Technologien der Zukunft angesehen. Ihre Nutzung erfolgt bereits in vielen Bereichen - unter anderem im eCommerce oder in der Roboter- oder Klimatechnik. Das Ziel von KI ist es, Maschinen zu befähigen, mit menschenähnlicher Intelligenz zu lernen, zu verstehen und zu handeln. Eine zentrale Herausforderung für die breite Adaption und Akzeptanz von KI ist die zurzeit geringe Nachvollziehbarkeit der getroffenen Entscheidungen. Um dieses Problem zu lösen, gibt es erste Ansätze der Explainable AI.

Was ist Explainable AI?

Erklärbare KI ist noch ein junges Forschungsfeld. Es existiert noch keine klare Definition. IBM definiert sie als „set of processes and methods that allows human users to comprehend and trust the results and output created by machine learning algorithms.“

Explainable AI fördert die Erklärbarkeit eines KI-Systems, indem es kritisch die Fragen nach dem Wie und Warum eines KI-Modells zu beantworten versucht.

Künstliche Intelligenz ist ein Teilgebiet der Informatik, die durch programmierte Abläufe oder maschinelles Lernen (ML) die maschinelle Intelligenz generiert. In den letzten Jahren wurden vor allem im Bereich des maschinellen Lernens große Fortschritte erzielt, was an der verbesserten Verfügbarkeit von großen Datenmengen und hoher Rechenperformance, die eine Grundvoraussetzung für die komplexen Berechnungen bei ML darstellen, liegt. In diesen Verfahren erlernt der Computer durch iterative Berechnungen, selbstständig eine Aufgabe zu erfüllen. Er orientiert sich hierzu an einem vorgegebenem Gütekriterium. So erhält z. B. ein selbstständig fahrendes Auto nur Informationen zu einer vorgegebenen Strecke. Wie diese absolviert wird, lernt es nur durch wiederholtes Ausprobieren und Feedback zu erfolgreichen Versuchen.

Ein großer Vorteil der KI ist, dass sie Prognosen verbilligt. KI macht Vorhersagen für die Zukunft. Sie kann Millionen von Bildern nach Anzeichen von Hautkrebs durchsuchen. KI kann für Simulationen von Warenströmen verwendet werden. KI kann individuelle Produktempfehlungen unter einer Vielzahl von Produkten geben.

Diese Kompetenz ist für die Entwicklung komplexer Systeme geeignet. KI-Systeme assistieren bei der Erhaltung der Gesundheit von Millionen von Menschen. KI-Systeme können helfen, den Warenverkehr in einer Fabrik radikal zu verbessern. Mittels KI-Systeme sind wir in der Lage, die Entwicklung berechenbarer Dinge besser vorhersehen zu können.

Die vier Prinzipien von Explainable AI

Das amerikanische National Institut of Standards and Technology (NIST) definiert vier Prinzipien von explainable AI.

Erklärung

Systeme liefern begleitende Beweise oder Gründe für die entsprechenden Ergebnisse.

Genauigkeit der Erklärung

Diese Erklärungen geben den Prozess des Systems zur Generierung der Ergebnisses korrekt wieder.

Bedeutsamkeit

Systeme geben Erklärungen, die für einzelne Benutzende verständlich sind.

Wissensgrenzen

Das System funktioniert nur unter Bedingungen, für die es entwickelt wurde.

Anwendungsbeispiel Kreditinstitut

Betrachten wir als ein Beispiel ein großes Kreditinstitut, in dem überwiegend viele hohe Kreditverträge abgeschlossen werden. Bei der Entscheidung zur Vergabe ziehen die Mitarbeiter und Mitarbeiterinnen ähnliche Fälle hinzu. Jedoch können sie aufgrund der Vielzahl an Anträgen nur wenige Vergleichsfälle sichten. Die Leitung des Instituts will den Angestellten ihre Arbeit erleichtern, indem Data Scientisten ein KI-Modell zur Kreditvergabe entwickeln. Damit soll der Entscheidungsfindungsprozess der Angestellten vereinfacht werden. Das KI-Modell soll alle bisherigen Kreditvergabefälle berücksichtigen und auf deren Basis eine Prognose erstellen. Zudem sollen die Angestellten mit dem Modell verschiedene (mögliche) Entwicklungen in der Zukunft (wie Zinserhöhungen) simulieren können.

Dieses hypothetische Beispiel, das auf einer realen Studie aus McKinsey’s The State of AI in 2020 basiert, zeigt die herausragende Bedeutung von Erklärbarkeit in der KI-Welt. In einem KI-Modell sind die Ausgangsdaten als Input für das Modell bekannt und das Modell gibt ein Ergebnis aus. Jedoch bleibt das Zustandekommen des Ergebnisses im Verborgenen. Aus diesem Grund stellen KI-Modelle eine Black-Box für die Anwendenden dar, so dass eine Nachvollziehbarkeit der Entscheidungsfindung nicht gegeben ist und Nutzende dem Modell nicht vertrauen. In der McKinsey Studie erhöhte sich die Akzeptanz des KI-Modells, sobald die Erklärbarkeit des Systems verbessert wurde.

Explainable AI schafft diese Erklärbarkeit. Darüber hinaus kann sie sogar zeigen, wie Algorithmen sich bei geänderten Rahmenbedingungen (wie Änderungen in der Altersverteilung) verhalten können. Diese Fragen stellen sich z. B. in den Bereichen Corporate Governance und Regulationen, und weisen viele rechtliche, soziale und ethische Implikationen auf. Einen bedeutenden rechtlichen Einfluss beinhaltet der EU AI Act, in dem die Europäische Union rechtliche Rahmenbedingungen für die KI-Nutzung setzt. Es ist das erste Gesetz weltweit, mit dem KI in allen Lebensbereichen reguliert werden soll. Nach diesem soll die KI „robust und ethisch“ sein.

Explainable AI erklärt die ML-Ergebnisse in verständlicher Weise für den Nutzenden. Es werden zwei Arten von Erklärungen unterschieden: Lokale Erklärungen liefern spezifische Vorhersagen des KI-Modells, d. h. es wird das Ergebnis für eine einzelne Beobachtung erläutert. Globale Erklärungen geben unter Berücksichtigung aller Beobachtungen Erklärungen für das Verhalten des gesamten KI-Modells.

Damit Nutzende die Ergebnisse des Explainable-AI-Prozesses verständlich nachvollziehen können, bietet sich deren Visualisierung in einem User Interface an. Dies ist Gegenstand von Explainable User Interface (XUI). Chromik/ Butz (2021) definieren XUI „as the sum of outputs of an Explainable AI process that the user can directly interact with“.

Anwendungsbeispiel Radiologie

Gegenstand der Analyse sind in diesem Bereich Röntgenbilder. Ein generiertes KI-Modell assistiert auf Basis einer großen Menge an Röntgenbildern den Radiolog*innen bei der Diagnose und liefert eine (globale) Erklärung zur generellen Funktionsweise des Modells. Wohingegen Patient*innen eine individuelle (lokale, also individuelle) Erklärung für die Diagnose wünschen.

An diesem Beispiel zeigt sich, dass unterschiedliche Stakeholder (Ärzt*innen, Patient*innen, Verbände) existieren, die ebenso unterschiedliche Fragestellungen an ein KI-System haben. In Deutschland bietet die Ärztekammer Ärzt*innen Unterstützung bei der Nutzung von KI-Systemen, indem es ihnen Hintergrundinformationen zu Möglichkeiten, Risiken und Limitationen liefert. Eine verlässliche Modellbeurteilung setzt ein Verständnis des gesamten KI-Systems voraus.

Anwendungsbeispiel Empfehlungsdienste

Empfehlungsdienste sind Online-Systeme, die Nutzer*innen auf Grundlage vorheriger Anfragen für sie interessante Produkte oder Dienste vorschlagen. Diese Systeme werden in unterschiedlichen Bereichen wie ECommerce oder in der Werbung eingesetzt.

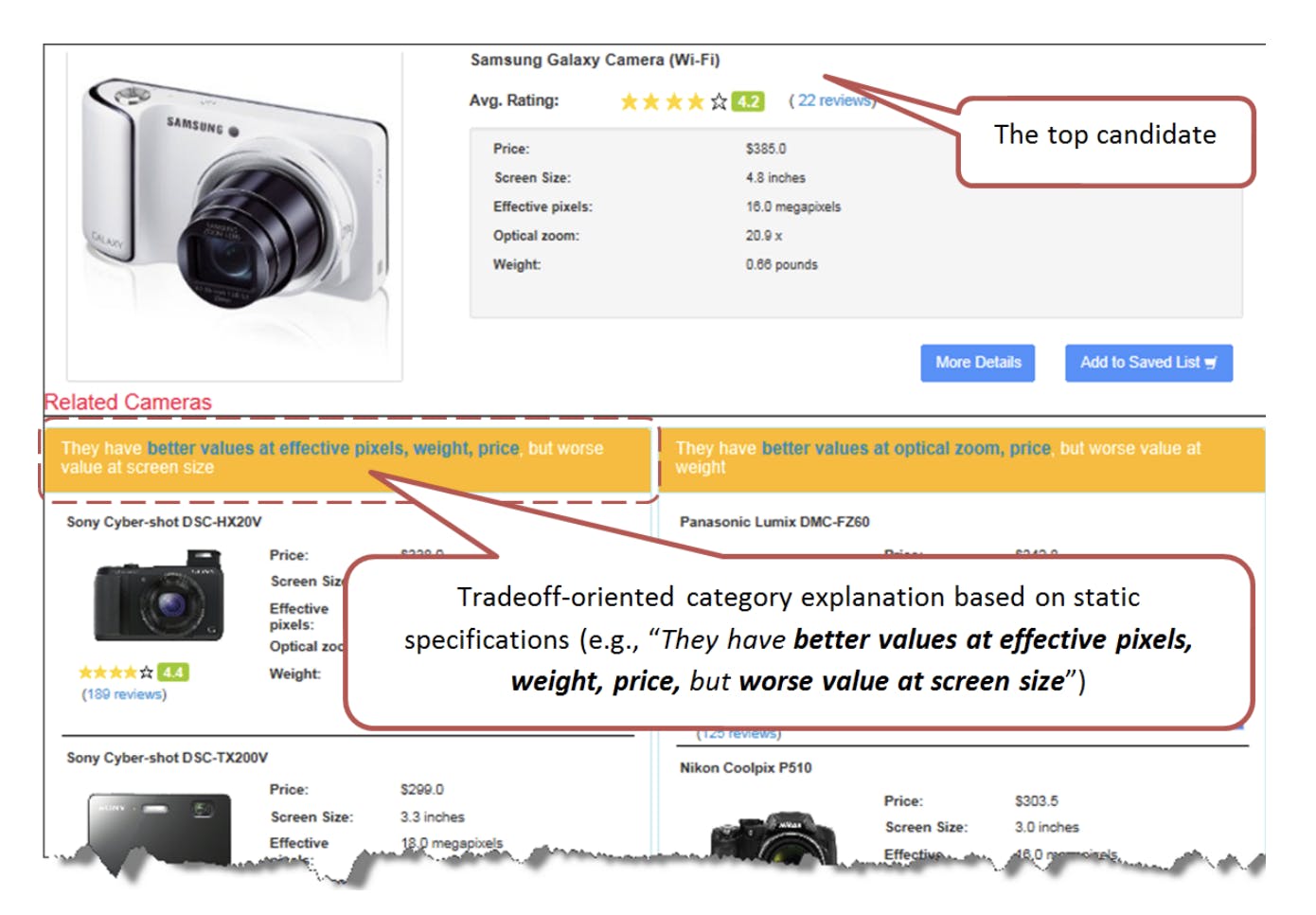

Ein Beispiel sind die Empfehlungen für eine Produktsuche auf einer ECommerce-Seite. Der Kunde/die Kundin sucht nach einem hochwertigen Produkt wie eine Digitalkamera. Die angezeigte Webseite enthält eine empfohlene Kamera. Weitere Produkteigenschaften wie Preis, Bildschirmgröße oder optischen Zoom, werden genutzt, um weitere, ähnliche Produkte anzuzeigen.

Quelle: http://www.comp.hkbu.edu.hk/~lichen/download/p17-chen.pdf

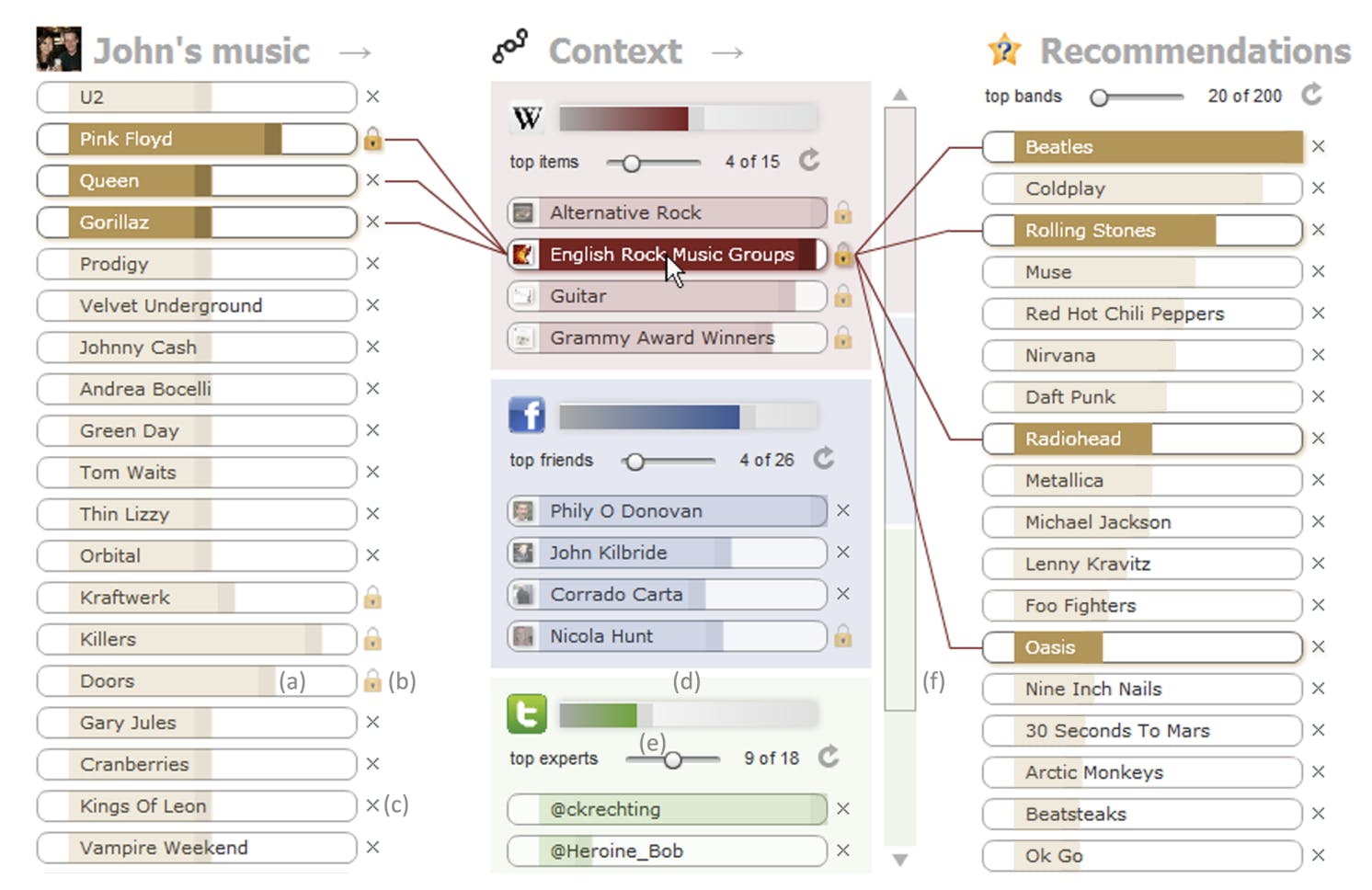

Als weiteres Beispiel dient ein universitäres Forschungsprojekt zu Liedempfehlungen, bei dem ein KI-Modell dem Nutzer/der Nutzerin Lieder empfiehlt. In dem Experiment entwickelte das Forscherteam ein User Interface, das erläuterte, wie sich die Empfehlungen durch Änderungen der Liedpräferenzen anpassen. Dies resultierte ebenfalls in einer höheren Akzeptanz seitens der Nutzenden.

In dem unten dargestellten User Interface stellt die linke Seite das Nutzerprofil dar. Die mittlere Spalte zeigt die verschiedenen Quellen, auf denen eine Liedempfehlung basiert. Ergebnisse der Empfehlungen präsentiert die dritte Spalte. Je nach Einstellungen ändern sich die Liedempfehlungen, gleichzeitig ist diese Empfehlung durch die transparente Quellendarstellung nachvollziehbar.

Quelle: https://sites.cs.ucsb.edu/~holl/pubs/Bostandjiev-2012-RecSys.pdf

Anwendungsbeispiel Autonomes Fahren

In Deutschland fahren seit Kurzem die ersten autonomen Fahrzeuge. So fährt in Nürnberg eine S-Bahn autonom, in Hamburg fuhr ein Bus mit 25 km/h im Testlauf 2020 durch die HafenCity. Ein spezieller Bereich des autonomen Fahrens ist der Einsatz an Orten, an denen es für Menschen zu gefährlich ist. Als Beispiele ist der Energiesektor oder das Militär zu nennen. In diesen Hochrisikoeinsätzen weisen die autonom fahrenden Fahrzeuge einen hohen Grad der Eigenständigkeit auf und sind deshalb gezwungen, ihr Handeln zu begründen.

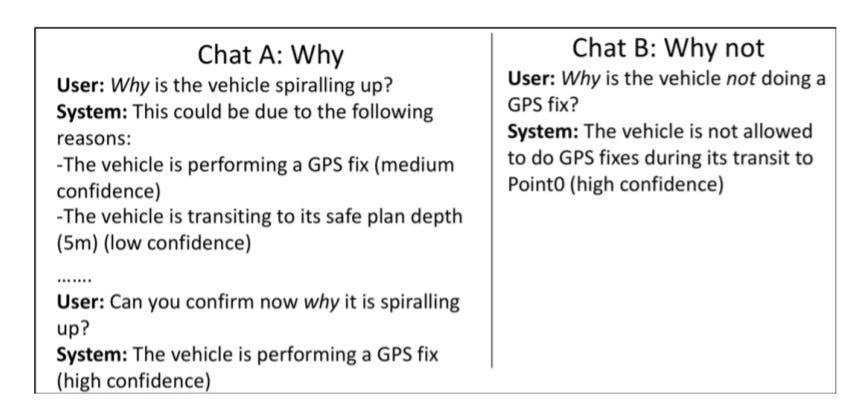

Die britische Marine entwickelte in einem Forschungsprojekt einen Chat-Agenten (als XUI-Erklärung) für ein Unterwasserfahrzeug, mit dem Nutzende interagieren können, um die Entscheidungen des autonomen Fahrzeugs nachzuvollziehen. In dem unten gezeigten Chatbeispiel zeigt (A) eine Angabe der wahrscheinlichen Gründe, warum das Fahrzeug ein Verhalten zeigen könnte, und (B) eine Erklärung des allgemeinen Verhaltens.

Explainable AI - Herausforderungen und Ausblick

In der jungen Forschung fehlt der Konsens bzgl. einer Definition von Explainable AI und Erklärbarkeit. Einige Forschende fokussieren sich dabei auf Visualisierungsmethoden, wohingegen andere das Konzept der Wichtigkeit einzelner Inputfaktoren betonen. Ein Grund für eine fehlende Standarddefinition liegt an den heterogenen Nutzenden. So nutzen z. B. AI-Forscher und ein Domänenexperte die ML-Techniken mit jeweils eigenen Zielen und benötigen dafür unterschiedliche Abstraktionslevel.

Eine der Herausforderungen für Explainable AI besteht in fehlenden Evaluationsmetriken der Erklärungen. In vielen statistischen Anwendungen existieren verschiedene, etablierte Maßzahlen für diverse Methoden, um die Güte eines Modells bewerten zu können. Für Explainable AI hingegen fehlt eine Maßzahl für die Beurteilung der „Erklärbarkeit“ eines Modells. Zudem ermöglicht ein Benchmarking den Vergleich der entsprechenden Methoden bei verschiedenen Anwendungen.

Eine weitere Herausforderung betrifft die Informationssicherheit eines Modells. Die Anwendung von Explainable-AI-Techniken zur Erklärbarkeit eines ML-Modells kann die Vertraulichkeit dieses Modells gefährden. So könnte jede Information eines Modells, die durch Explainable-AI-Erklärungen enthüllt wird, genutzt werden, um das Modell durch Angriffe zu verwirren. Diese Attacken können das Modell manipulieren und zu einem anderen Ergebnis führen.

Das Interesse an Explainable AI steigerte sich bereits in den letzten Jahren. Getrieben von der EU Forderung nach erklärbaren KI-Modellen wird es zukünftig weitere spannende Entwicklungen geben.

Sie haben Fragen zum Thema Explainable AI?

Unser KI-Experte Oliver Toma beantwortet sie gerne!