Deployment eines eigenen Sprachmodells

Large Language Models (LLMs) haben die Art und Weise revolutioniert, wie wir mit Texten umgehen und maschinelles Lernen anwenden. Sie bieten eine beeindruckende Fähigkeit zur Textgenerierung und ein tieferes Verständnis von Sprache im Vergleich zu kleineren Modellen des Natural Language Processing (NLP). Welche Unterschiede es gibt, welche Herausforderungen es beim Deployment von LLMs zu meistern gilt und wann es sinnvoll ist, auf kleinere Modelle zurückzugreifen, erläutert dieser Artikel. Außerdem werden wir die Vor- und Nachteile des selbst gehosteten LLMs diskutieren und die Kriterien für die Entscheidung zwischen On-Premises und Cloud erläutern.

Was unterscheidet Large Language Models von kleineren NLP-Modellen?

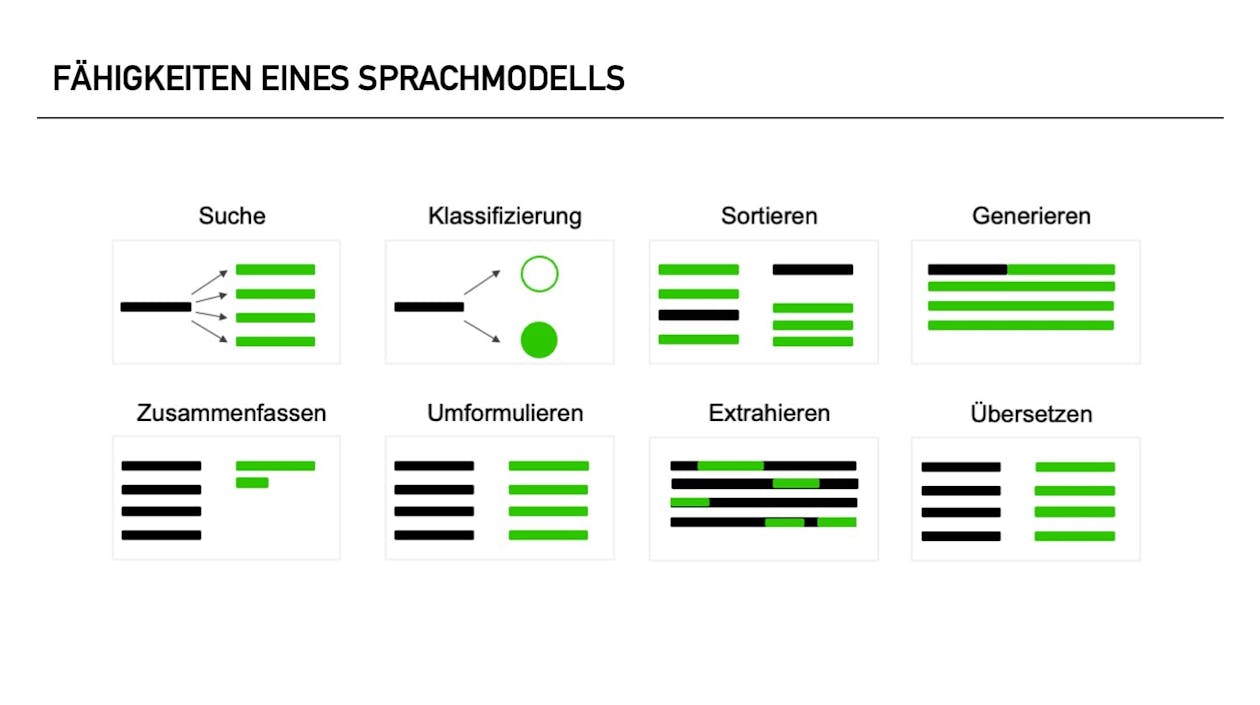

LLMs zeichnen sich durch ihre beeindruckende Größe und Komplexität aus. Sie werden mit einer sehr großen Menge an Textdaten trainiert und verfügen über eine enorme Anzahl von Parametern. Im Vergleich zu kleineren NLP-Modellen haben LLMs eine bessere Fähigkeit, kontextbezogene Texte zu generieren und Sprachmuster zu verstehen. Sie können komplexere Aufgaben wie maschinelle Übersetzung, Textverständnis und Dialogsysteme effektiver bewältigen. Im Gegensatz zu kleineren NLP-Modellen sind LLMs auch auf mehrere Aufgaben gleichzeitig trainiert worden. So steht beispielsweise das T5-Modell für Transformer (Model-Architektur) mit fünf unterschiedlichen Fähigkeiten. Kleinere NLP-Modelle sind in der Regel auf eine einzige Aufgabe trainiert und nicht multifunktional einsetzbar. Die meisten Sprachmodelle können mindestens einem der folgenden acht Aufgaben zugeordnet werden:

Mehr Informationen dazu finden Sie in unserem speziellen Artikel zu den Fähigkeiten von Large Language Models.

Wie trainiert man ein LLM auf eigene Daten?

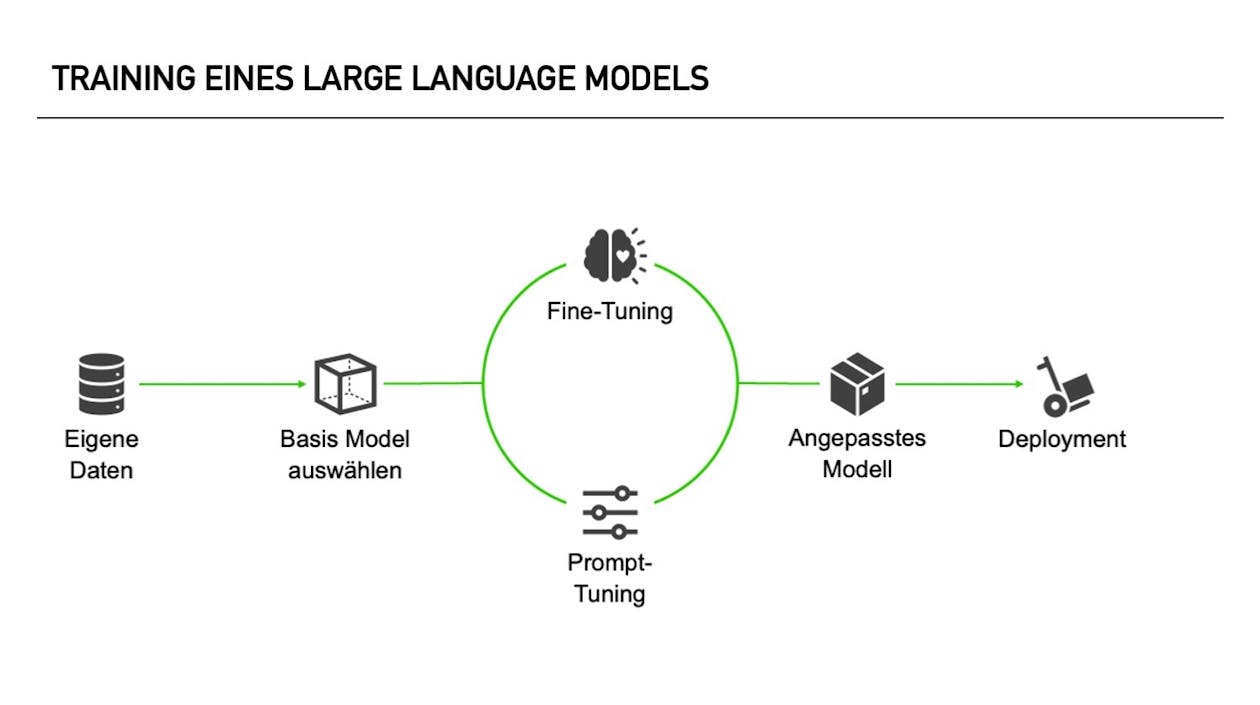

Das Training eines Large Language Models auf eigene Daten erfordert einige spezifische Schritte.

- Vorbereitung der Daten: Um ein LLM auf eigene Daten zu trainieren, müssen Sie zunächst über einen ausreichend großen und qualitativ hochwertigen Datensatz verfügen, der Ihre spezifische Aufgabe oder Domäne abdeckt. Dieser Datensatz kann aus verschiedenen Textquellen wie Büchern, Webseiten, Fachpublikationen oder internen Dokumenten stammen. Die Daten müssen in einem maschinenlesbaren Format vorliegen und aufbereitet werden, um das Training effizient zu gestalten.

- Auswahl des LLM-Modells: Es gibt verschiedene vortrainierte LLM-Modelle zur Auswahl, die als Ausgangspunkt für das Training mit eigenen Daten dienen. Diese Modelle sind bereits mit großen, allgemeinen Textdaten vortrainiert und verfügen über ein grundlegendes Sprachverständnis. Beliebte LLM-Modelle sind beispielsweise GPT-3, BERT oder Transformer.

- Fine-Tuning: Das eigentliche Training auf den eigenen Daten erfolgt durch den Prozess des Fine-Tunings (Feinabstimmung). Hierbei werden die Gewichte und Parameter des vortrainierten Modells an die spezifischen Eigenschaften und Anforderungen Ihrer Daten angepasst. Durch das Feintuning auf eigenen Daten erlernt das Modell die Sprachmuster und spezifischen Zusammenhänge Ihrer Domäne.

- Trainingsprozess: Das Training eines LLMs erfordert eine leistungsstarke Hardware, wie z.B. Graphics Processor Units (GPUs) oder Tensor Processing Units (TPUs), um die erforderliche Rechenleistung zu bieten. Der Trainingsprozess besteht aus mehreren Durchläufen (Epochen), bei denen das Modell die Trainingsdaten wiederholt durchläuft, um seine Parameter anzupassen und die Leistung zu verbessern. Je nach Umfang des Datensatzes und der Komplexität der Aufgabe kann das Training mehrere Stunden oder sogar Tage dauern.

- Evaluation und Feinabstimmung: Nach dem Training müssen Sie das Modell evaluieren, um die Qualität der Ergebnisse zu bewerten. Dazu können Sie Testdaten verwenden, die nicht im Trainingsdatensatz enthalten waren. Basierend auf der Evaluierung können Sie das Modell weiter optimieren und feinabstimmen, um bessere Ergebnisse zu erzielen. Dieser iterative Prozess kann mehrere Durchgänge erfordern, um die gewünschte Leistung zu erreichen.

Es ist wichtig zu beachten, dass das Training eines LLMs auf eigenen Daten Ressourcen, Fachwissen und Zeit erfordert. Der Prozess beansprucht in der Regel ein Team von Data Scientists oder maschinellen Lernexperten, um die beste Vorgehensweise zu bestimmen und das Training effektiv durchzuführen.

Abschließend kann gesagt werden, dass das Training eines LLMs auf eigenen Daten eine Möglichkeit ist, maßgeschneiderte und auf spezifische Anforderungen zugeschnittene Sprachmodelle zu erstellen. Es erfordert jedoch eine sorgfältige Planung, Vorbereitung der Daten und entsprechende Ressourcen, um erfolgreich zu sein.

Warum oder wann braucht Ihr Unternehmen ein fein abgestimmtes Large Language Model?

Wenn ein Sprachmodell speziell auf die Bedürfnisse eines Unternehmens oder einer Organisation angepasst werden soll, nennt man das Fine-Tuning. Unternehmen benötigen je nach ihren spezifischen Anforderungen, ihrer Branche und ihren Zielen aus verschiedenen Gründen feinabgestimmte große Sprachmodelle. Hier sind einige häufige Gründe:

- Anpassung: Unternehmen haben oft besondere Bedürfnisse und Ziele, die ein allgemeines Sprachmodell nicht erfüllen kann. Die Feinabstimmung ermöglicht es ihnen, das Verhalten des Modells auf ihre spezifischen Ziele zuzuschneiden, z. B. die personalisierte Marketinginhalte zu erstellen oder ein Verständnis von nutzergenerierten Inhalten auf ihrer Plattform zu erlangen.

- Datensensibilität und Compliance: Unternehmen, die mit sensiblen Daten umgehen oder unter strengen gesetzlichen Auflagen arbeiten, müssen das Modell unter Umständen fein abstimmen, um sicherzustellen, dass es die Datenschutzbestimmungen respektiert, sich an die Inhaltsrichtlinien hält und angemessene Antworten generiert, die den Branchenvorschriften entsprechen.

- Bereichsspezifische Sprache: In vielen Branchen werden Jargon, Fachbegriffe und spezielles Vokabular verwendet, die in den allgemeinen Trainingsdaten eines großen Sprachmodells möglicherweise nicht gut repräsentiert sind. Durch die Feinabstimmung des Modells anhand bereichsspezifischer Daten kann es genaue Antworten im Kontext der Branche des Unternehmens verstehen und generieren.

- Verbesserte Leistung: Die Feinabstimmung verbessert die Leistung des Modells bei spezifischen Aufgaben oder Anwendungen, die für das Unternehmen relevant sind, wie z. B.:

- Analyse von Gefühlen

- Klassifizierung von Dokumenten

- Informationsextraktion

Dies kann zu einer besseren Entscheidungsfindung, höherer Effizienz und besseren Ergebnissen führen. - Verbesserte Benutzerfreundlichkeit: Ein fein abgestimmtes Modell kann eine bessere Benutzererfahrung bieten, indem es genauere, relevantere und kontextbezogene Antworten generiert, die zu einer höheren Kundenzufriedenheit führen, z. B. in Anwendungen wie:

- Chatbots

- Virtuelle Assistenten

- Kundensupport-Systeme

Deployment von Large Language Models

Das Deployment stellt einige Herausforderungen dar. LLMs benötigen erhebliche Rechenleistung und Speicheranforderungen. LLMs benötigen mit GPUs bzw. Grafikkarten spezialisierte Hardware, um optimale Leistung zu erzielen, und ihre Bereitstellung erfordert technisches Fachwissen. Es ist ratsam, auf ein kleineres Modell zurückzugreifen, wenn die spezifische Aufgabe, die Sie lösen möchten, lediglich eine der acht o.g. Aufgaben erfüllen soll oder die Aufgaben sich so gut voneinander trennen lassen, dass mehrere kleinere NLP-Modelle genutzt werden können, um gute Ergebnisse zu erzielen. Kleinere Modelle haben oft geringere Bereitstellungsanforderungen und sind einfacher zu handhaben.

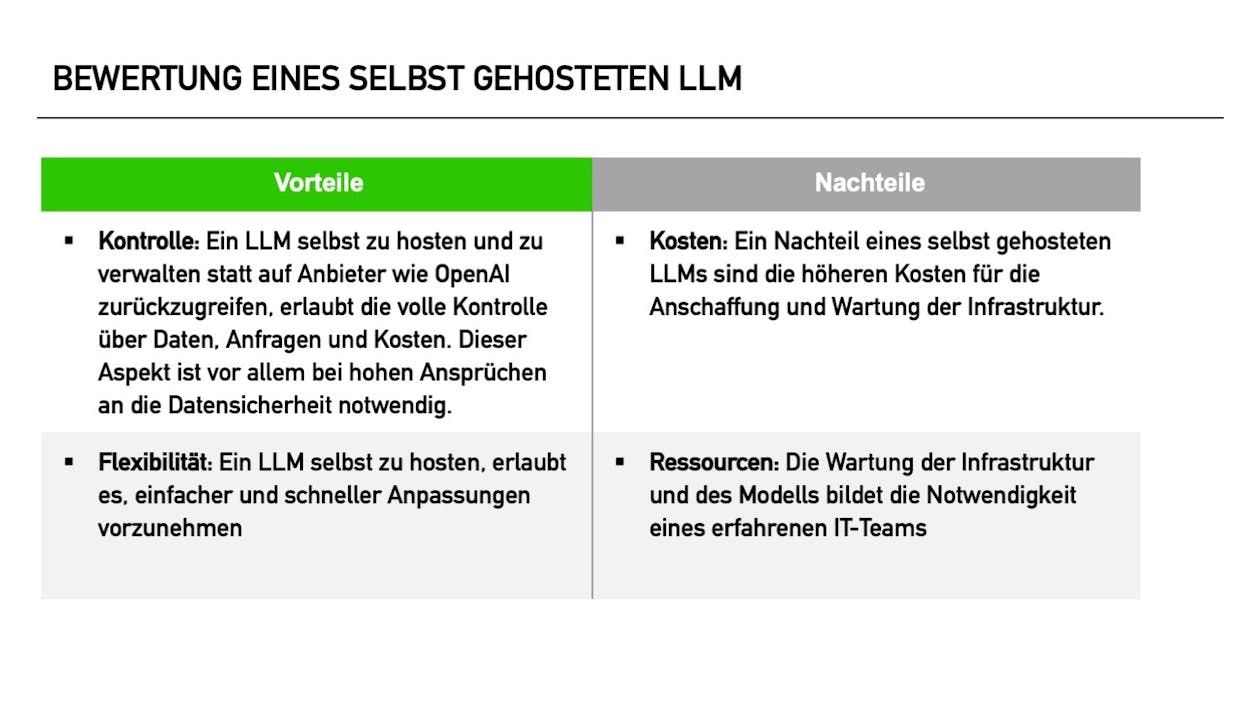

Vor- und Nachteile für ein selbst gehostetes Large Language Model

Kriterien für die Entscheidung zwischen On-Premises und Cloud

Bei der Wahl des Hostings sollten mehrere Kriterien berücksichtigt werden. Dazu gehören:

- Verfügbarkeit von Ressourcen,

- Skalierbarkeitsanforderungen,

- Sicherheitsbedenken,

- Budget

- Fachkenntnisse des Teams.

Cloud Hosting bietet eine schnellere Bereitstellung, einfache Skalierbarkeit und reduziert den anfänglichen Investitionsaufwand, während On-Premises mehr Kontrolle und Sicherheit bietet.

Rechenbeispiel für das Deployment eines LLMs

Angenommen, ein Unternehmen plant das Deployment eines LLMs in der Lambda Cloud. Das Modell soll 1.000 Anfragen pro Stunde verarbeiten, wobei jede Anfrage drei Sekunden Rechenzeit benötigt. Diese Anforderungen können je nach Modellgröße schon von einer 80 vRAM und NVIDIA H100 GPU Instanz erfüllt werden. Der Cloud-Anbieter berechnet 0,0373€ pro Sekunde Rechenzeit und 0,0001€ pro Anfrage für Datenübertragungskosten.

Rechenbeispiel für das Deployment eines LLMs

Angenommen, ein Unternehmen plant das Deployment eines LLMs in der Lambda Cloud. Das Modell soll 1.000 Anfragen pro Stunde verarbeiten, wobei jede Anfrage drei Sekunden Rechenzeit benötigt. Diese Anforderungen können je nach Modellgröße schon von einer 80 vRAM und NVIDIA H100 GPU Instanz erfüllt werden. Der Cloud-Anbieter berechnet 0,0373€ pro Sekunde Rechenzeit und 0,0001€ pro Anfrage für Datenübertragungskosten.[1]

Die Kosten pro Stunde berechnen sich wie folgt:

- Rechenzeit: 100 Anfragen/Stunde * 3 Sekunden/ Anfrage * 0,0373€/Sekunde = 11,19€/Stunde

- Datenübertragungskosten: 100 Anfragen/ Stunde * 0,0001€ /Anfrage = 0,1€/Stunde

- Gesamtkosten: 0,1€/Stunde + 11,19€/ Stunde = 11,20€/Stunde

Bei der Annahme von 250 Arbeitstagen im Jahr, an denen das Modell zur Verfügung stehen soll, wären das bei einer Bereitstellungsdauer von ca. 12 Stunden am Tag 33.600€.

Dabei sind noch keine Arbeitsstunden für die Wartung bzw. das Anpassen des Modells berücksichtigt. Darüber hinaus gehen wir hier von einer bedarfsorientierten Bereitstellung aus, sodass der Service nicht dauerhaft läuft, sondern nur bei Bedarf hochgefahren wird.

Lohnt sich das? Das kommt auf den Use-Case an. Ein klassisches Szenario ist die Unterstützung des First Level Support mit Sprachmodellen. Die Sprachmodelle können viele eher weniger Komplexe Probleme von Kunden lösen, sodass die Mitarbeitenden im Support sich um die wichtigen Fälle kümmern. Das entlastet Ihre Mitarbeiter und spart deutlich Überstunden.

[1] Ungefähre Schätzung basierend auf https://lambdalabs.com/service/gpu-cloud/pricing

Unterschiede zwischen On-Premises und Cloud

On-Premise-Hosting erfordert, dass Unternehmen ihre eigenen Server und Infrastruktur bereitstellen und warten. Es bietet volle Kontrolle und Datensicherheit, erfordert jedoch erhebliche Investitionen in Hardware und Expertise. Cloud Hosting nutzt die Infrastruktur eines Cloud-Anbieters, was eine schnellere Bereitstellung und Skalierbarkeit ermöglicht. Es reduziert den anfänglichen Investitionsaufwand, erfordert jedoch eine Abhängigkeit vom Cloud-Anbieter und kann höhere laufende Kosten haben. Bedarfsorientierte Skalierung, wie im Rechenbeispiel, kann in einem On-Premise Szenario komplizierter sein und zu weiteren Kosten führen.

Fazit

Das Deployment von Large Language Models stellt Unternehmen vor Herausforderungen, aber auch enorme Möglichkeiten zur Verbesserung von Textgenerierung und maschinellem Lernen. Die Wahl zwischen einem LLM und einem kleineren Modell hängt von der Komplexität der Aufgabe und den verfügbaren Ressourcen ab. Die Entscheidung zwischen On-Premises und Cloud erfordert eine sorgfältige Abwägung von Kontrolle, Skalierbarkeit, Sicherheit und Kosten. Letztendlich sollte das Ziel sein, eine Lösung zu finden, die den Anforderungen des Unternehmens am besten entspricht und die besten Ergebnisse liefert.

Unsere Leistungen greifen ineinander – entdecken Sie weitere Ansätze

Wenn Sie Sprachmodelle für sich nutzen möchten und Unterstützung bei der Ideenfindung, der Implementierung oder der Auswahl von Modellen und Architekturen benötigen, ist Cassini Consulting Ihr Partner. Wir bieten Ihnen Hilfe bei der genauen Kalkulation oder der Validierung Ihres Use-Cases und unterstützen Sie mit unserer Expertise. Methodisch, konzeptionell oder ganz praktisch und Hands-On bei der Implementierung.

*Pflichtangaben